徒手打造基于Spark的數據工廠 從設計到實現數據分析和存儲服務

隨著大數據時代的到來,企業對于高效、可擴展的數據處理需求日益增長。Apache Spark憑借其強大的分布式計算能力和易用性,成為構建數據工廠(Data Factory)的理想選擇。本文將詳細介紹如何從零開始設計和實現一個基于Spark的數據工廠,涵蓋數據分析和存儲服務的核心環節。

1. 數據工廠設計概述

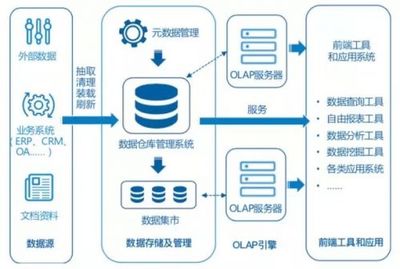

數據工廠是一個集數據采集、處理、分析和存儲于一體的平臺,其核心目標是為企業提供可靠的數據服務。在設計階段,需明確以下關鍵組件:

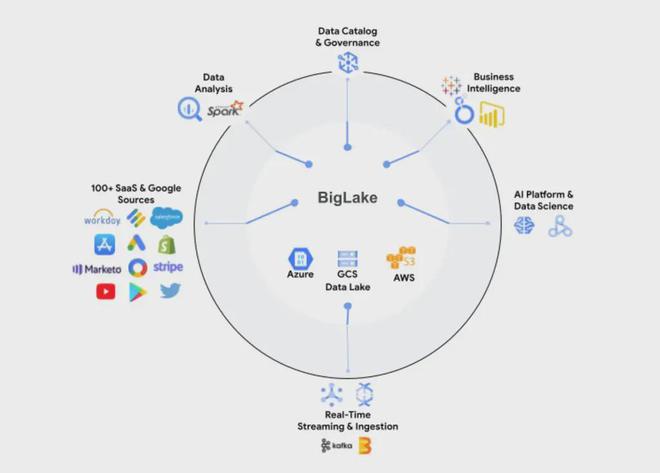

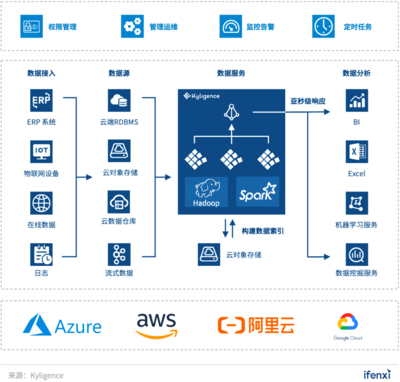

- 數據源接入:支持多種數據源,如數據庫、日志文件、實時流數據等。

- 數據處理引擎:基于Spark進行分布式計算,實現ETL(提取、轉換、加載)操作。

- 數據分析模塊:利用Spark MLlib或SQL進行數據挖掘和機器學習任務。

- 數據存儲服務:將處理后的數據持久化到HDFS、數據湖或云存儲中。

- 調度與監控:使用工具如Apache Airflow進行任務調度,并集成監控告警機制。

2. 實現步驟詳解

2.1 環境搭建與Spark配置

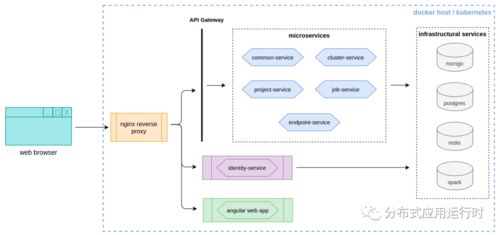

部署Spark集群,可選擇Standalone、YARN或Kubernetes模式。配置Spark參數以優化資源利用,例如設置executor內存、并行度等。確保集群支持Scala、Python或Java開發,以適應不同團隊需求。

2.2 數據采集與接入

通過Spark的DataSource API或自定義連接器,接入結構化數據(如MySQL、PostgreSQL)和非結構化數據(如JSON、CSV文件)。對于實時數據流,可結合Spark Streaming或Structured Streaming處理Kafka等消息隊列數據。

2.3 核心數據處理

利用Spark DataFrame和SQL進行數據清洗、轉換和聚合。例如,處理缺失值、去重、數據格式標準化等。編寫可重用的ETL作業,確保數據質量。代碼示例如下(使用PySpark):`python

from pyspark.sql import SparkSession

spark = SparkSession.builder.appName("DataFactory").getOrCreate()

df = spark.read.format("csv").load("datasource.csv")

dfcleaned = df.dropDuplicates().fillna({"columnname": "defaultvalue"})

dfcleaned.write.parquet("outputpath")`

2.4 數據分析服務

集成Spark MLlib進行機器學習任務,如分類、聚類或推薦系統。同時,使用Spark SQL執行復雜查詢,生成業務報表。通過REST API或可視化工具(如Grafana)暴露分析結果,賦能決策。

2.5 數據存儲與優化

將處理后的數據存儲到分布式文件系統(如HDFS)或云存儲(如AWS S3)。針對不同場景選擇合適的存儲格式,如Parquet用于分析、Avro用于序列化。實施分區和壓縮策略以提升查詢性能。

2.6 調度與運維

使用Apache Airflow或類似工具編排數據管道,設置依賴關系和定時任務。集成監控系統(如Prometheus)跟蹤作業狀態和資源使用情況,確保高可用性和故障恢復。

3. 挑戰與最佳實踐

在實現過程中,可能面臨數據一致性、性能瓶頸等問題。建議遵循以下最佳實踐:

- 采用增量處理減少資源消耗。

- 實施數據版本控制以管理變更。

- 定期進行性能調優和測試。

通過本文的指導,您可以逐步構建一個健壯的基于Spark的數據工廠,實現高效的數據分析和存儲服務,助力企業數據驅動決策。

如若轉載,請注明出處:http://www.car163.com.cn/product/6.html

更新時間:2026-02-14 06:19:28