Apache Hudi 中表的存儲類型及其在數據分析和存儲服務中的應用

Apache Hudi(Hadoop Upserts Deletes and Incrementals)是一個開源的數據湖框架,旨在簡化大數據處理中數據的增量更新、刪除和查詢。在 Hudi 中,表的存儲類型是其核心概念之一,它決定了數據如何組織、存儲和訪問。Hudi 主要提供兩種存儲類型:Copy-on-Write(COW)和 Merge-on-Read(MOR)。這些存儲類型對數據分析和存儲服務的效率、延遲和資源使用有直接影響。

我們來詳細解釋 Hudi 的兩種存儲類型。Copy-on-Write(COW)類型在寫入數據時直接更新現有文件,每次更新都會生成新的文件版本,這確保了數據的一致性,但可能增加寫入延遲和存儲開銷。COW 適用于讀多寫少的場景,因為它提供優化的查詢性能,數據始終處于可讀狀態。例如,在數據分析服務中,如果需要對數據進行頻繁的查詢和報告,COW 類型可以快速響應,同時保持數據的 ACID 特性。

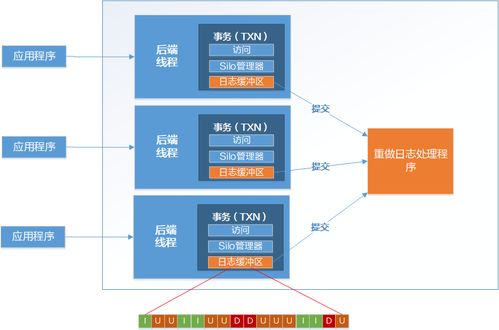

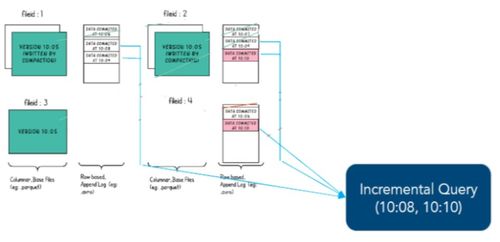

相比之下,Merge-on-Read(MOR)類型將更新和刪除操作記錄在增量日志文件中,而不是立即合并到底層數據文件中。這減少了寫入延遲,因為不需要每次更新都重寫整個文件,但讀取時可能需要合并日志和基礎文件,從而增加讀取延遲。MOR 類型適用于寫多讀少的場景,例如實時數據攝取或流處理服務,它允許高效的數據更新,同時支持近實時的查詢。在存儲服務中,MOR 可以幫助管理高吞吐量的數據流入,減少存儲成本,因為基礎文件可以保持不變,僅通過日志處理變更。

在數據分析和存儲服務中,選擇合適的 Hudi 存儲類型至關重要。對于數據分析應用,如果重點是快速查詢和低延遲讀取,COW 類型更合適,因為它提供優化的列式存儲格式(如 Parquet),與 Apache Spark 和 Presto 等查詢引擎無縫集成。相反,對于存儲服務,特別是處理實時數據管道或需要頻繁更新的場景,MOR 類型更能平衡寫入性能和存儲效率。Hudi 還支持事務性保證和增量查詢,這進一步增強了其在數據湖架構中的實用性,幫助組織構建可靠的數據平臺。

Apache Hudi 的存儲類型為數據管理和分析提供了靈活性。COW 和 MOR 各有優勢,用戶應根據具體用例(如批處理分析、實時流處理或混合負載)來選擇。通過合理配置,Hudi 可以顯著提升數據湖的性能和可擴展性,支持現代數據驅動的業務需求。

如若轉載,請注明出處:http://www.car163.com.cn/product/21.html

更新時間:2026-02-14 18:45:01